Introducción

La elección de GPU para implementaciones empresariales de modelos de lenguaje grandes (LLM) puede impactar significativamente en los costos operativos y la eficiencia de la infraestructura de IA. Un estudio comparativo reciente entre la AMD W7900 y una configuración dual de NVIDIA RTX 3090 revela diferencias sorprendentes en rendimiento y eficiencia energética que todo decisor tecnológico debería conocer.

Principales Hallazgos del Estudio

Rendimiento vs Eficiencia Energética

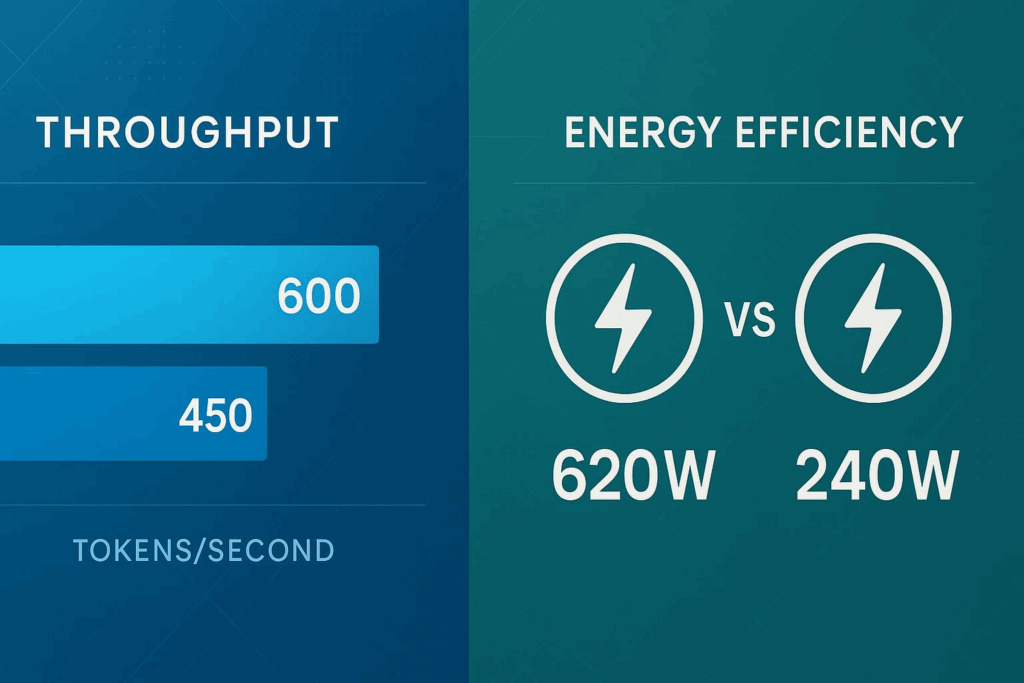

El análisis, realizado utilizando el modelo Qwen 2.5 AWQ de 14B parámetros en un entorno empresarial controlado, demostró resultados que desafían las expectativas tradicionales:

- NVIDIA (2 x RTX 3090): 600 tokens/segundo con consumo de 620 watts

- AMD W7900: 450 tokens/segundo con consumo de solo 240 watts

Eficiencia de Costos Operativos

Los datos revelan que la AMD W7900 consume aproximadamente la mitad de energía por token procesado, presentando una propuesta de valor atractiva para empresas que buscan optimizar costos operativos a largo plazo.

Consideraciones Estratégicas para Implementación

Simplicidad vs Complejidad

Mientras la configuración NVIDIA requiere tensor parallelism y gestión de múltiples GPUs, la solución AMD ofrece:

- Configuración de hardware simplificada

- Menor complejidad de gestión

- Reducción en requerimientos de infraestructura

Casos de Uso Recomendados

Para máximo throughput: La configuración NVIDIA mantiene ventajas cuando el rendimiento bruto es prioritario.

Para eficiencia y simplicidad: La AMD W7900 sobresale en implementaciones que priorizan retorno de inversión y sostenibilidad energética.

Conclusiones para Decisores Tecnológicos

Este estudio demuestra que la elección entre estas plataformas debe basarse en objetivos estratégicos específicos más que en preferencias de marca. Las empresas que buscan optimizar el balance entre rendimiento y eficiencia operativa encontrarán en los resultados completos información valiosa para la toma de decisiones.

La implementación exitosa de infraestructura de IA empresarial requiere considerar no solo el rendimiento inicial, sino también los costos operativos continuos y la complejidad de gestión a largo plazo.

📊 Para acceder a los datos completos del estudio, métricas detalladas de latencia y análisis técnico profundo, ingresa acá: Estudio completo de inferencia local de LLMs

Fuentes

- Dolfs.io – Estudio comparativo «Inferencia local de LLM’s AMD W7900 vs 2x Nvidia RTX 3090»

- JhedAI – Análisis de rendimiento de GPUs para IA empresarial

- EsferaIA – Evaluación de infraestructura para modelos de lenguaje grandes

¿Necesitas asesoría para implementar infraestructura de IA en tu empresa? Nuestro equipo puede ayudarte a evaluar la mejor configuración según tus necesidades específicas.