En un entorno empresarial donde la eficiencia operativa y la innovación tecnológica marcan la diferencia competitiva, la integración de Modelos de Lenguaje de Gran Tamaño (LLMs) en aplicaciones de negocio ha dejado de ser una opción para convertirse en una necesidad estratégica. Como señala Prasann Pradeep Patil, «GenAI tiene aplicaciones en el mundo real. También genera ingresos para las empresas, por lo que esperamos que las compañías inviertan fuertemente en investigación».

En JhedAI entendemos que muchas organizaciones se encuentran en diferentes puntos del espectro de adopción de IA generativa: desde la fase de exploración inicial hasta la necesidad de implementaciones sofisticadas. Este artículo proporciona una hoja de ruta práctica para aprovechar el poder de los LLMs en sus aplicaciones empresariales.

1. Definición clara del caso de uso

Antes de sumergirse en la implementación técnica, es fundamental establecer objetivos concretos y medibles. Como recomienda Patil, debe comenzar haciéndose algunas preguntas clave:

- ¿Qué problema resolverá mi LLM?

- ¿Puede mi aplicación funcionar sin LLM?

- ¿Dispongo de suficientes recursos y capacidad de cómputo para desarrollar y desplegar esta aplicación?

Un caso de uso bien definido podría ser, por ejemplo, un chatbot capaz de consultar información dispersa en wikis corporativas, canales de Slack y documentación interna para responder a consultas de clientes de manera autónoma.

Esta definición clara del objetivo no solo guía el desarrollo técnico, sino que también establece métricas de éxito desde el principio, facilitando la evaluación posterior del rendimiento y el retorno de la inversión.

2. Selección del modelo adecuado

La elección del modelo es una decisión crítica que debe alinearse con las necesidades específicas de su aplicación. Según Patil, existen dos enfoques principales:

Entrenamiento desde cero vs. Modelos pre-entrenados

Para la mayoría de las aplicaciones empresariales, los modelos pre-entrenados ofrecen un equilibrio óptimo entre esfuerzo y resultado. «Entrenar su modelo desde cero requerirá una enorme potencia de cálculo, importantes esfuerzos de ingeniería y costos, entre otras cosas», advierte Patil.

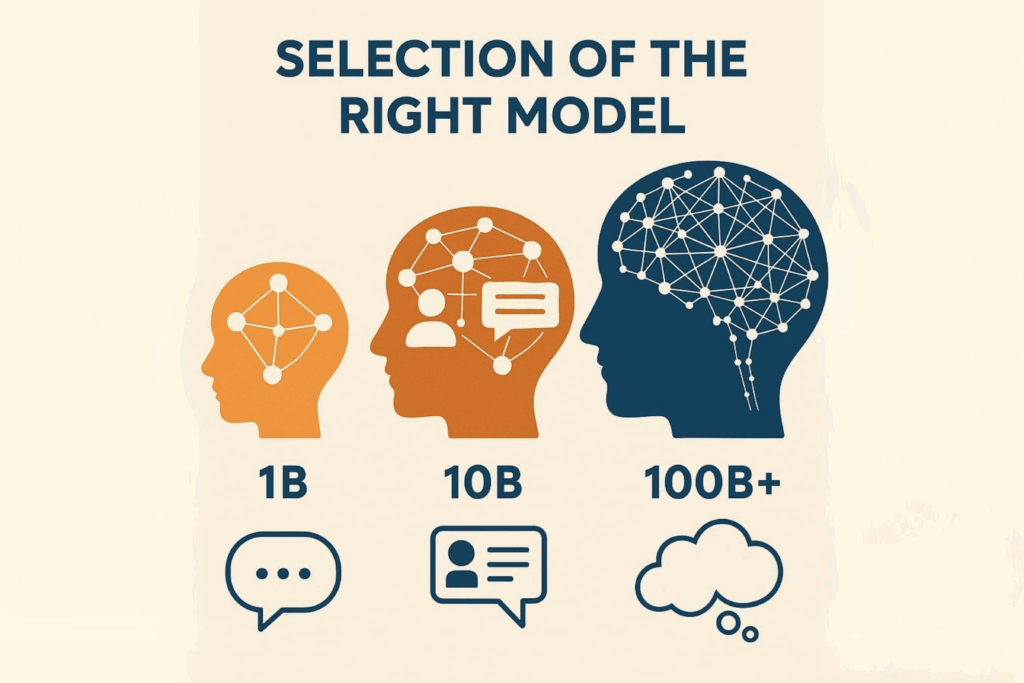

Dimensionamiento según complejidad

El tamaño del modelo debe corresponder a la complejidad de las tareas requeridas:

- Modelos de 1B parámetros: Conocimientos básicos y reconocimiento de patrones. Adecuados para aplicaciones como análisis de reseñas.

- Modelos de 10B parámetros: Excelente conocimiento y capacidad para seguir instrucciones. Ideal para chatbots de pedidos o sistemas de atención al cliente.

- Modelos de 100B+ parámetros: Conocimiento amplio del mundo y razonamiento complejo. Apropiados para tareas de brainstorming o análisis sofisticados.

Esta segmentación permite optimizar recursos, destinando la capacidad computacional necesaria según la complejidad de la tarea, sin sobredimensionar la infraestructura.

3. Enriquecimiento del modelo con datos propietarios

Una vez seleccionado el modelo base, el siguiente paso es personalizarlo con información específica de su negocio. Patil destaca dos enfoques principales:

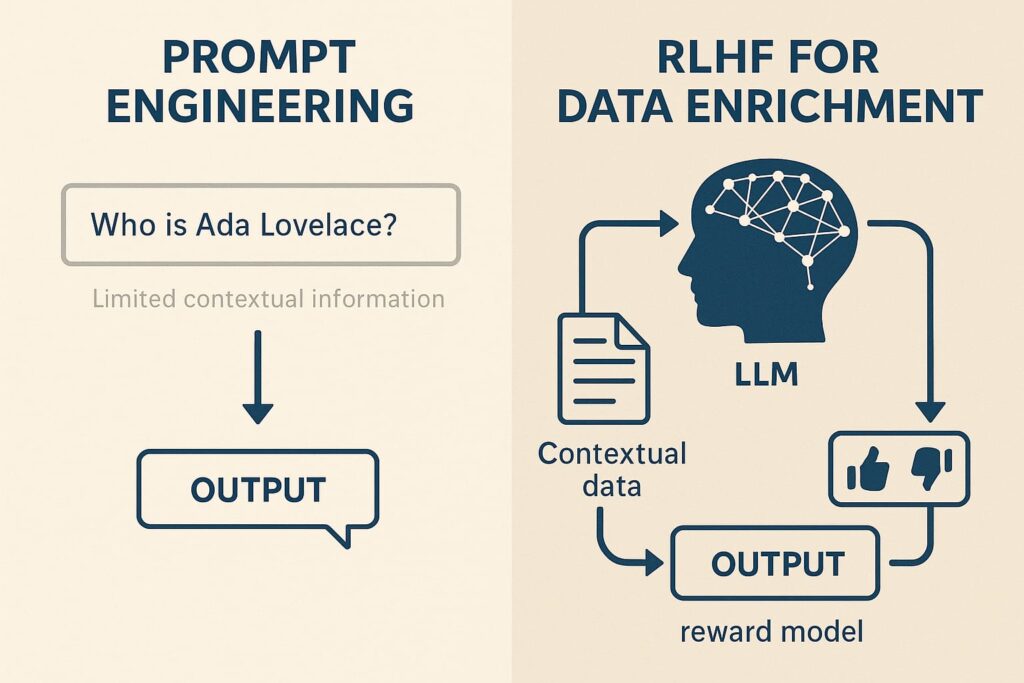

Ingeniería de prompts

El método más sencillo consiste en enriquecer las entradas con contexto adicional durante la inferencia. Por ejemplo:

"Clasifica esta reseña

Me encanta la película

Sentimiento: Positivo

Clasifica esta reseña

Odié la película.

Sentimiento: Negativo

Clasifica la película

El final fue emocionante"Sin embargo, este enfoque tiene limitaciones importantes: «No puedes proporcionar un contexto amplio dentro del prompt. Hay un límite para el contexto del prompt. Además, no puedes esperar que el usuario siempre proporcione el contexto completo».

Aprendizaje Reforzado con Retroalimentación Humana (RLHF)

Una estrategia más sofisticada es implementar RLHF, que permite al modelo aprender iterativamente de datos contextuales. Como explica Patil, «proporcionas algunos datos contextuales para que el modelo aprenda». En este proceso:

- El modelo genera una salida basada en el contexto actual

- Un modelo de recompensa evalúa la calidad de la respuesta

- El modelo actualiza sus pesos para maximizar la recompensa

- Este ciclo se repite iterativamente

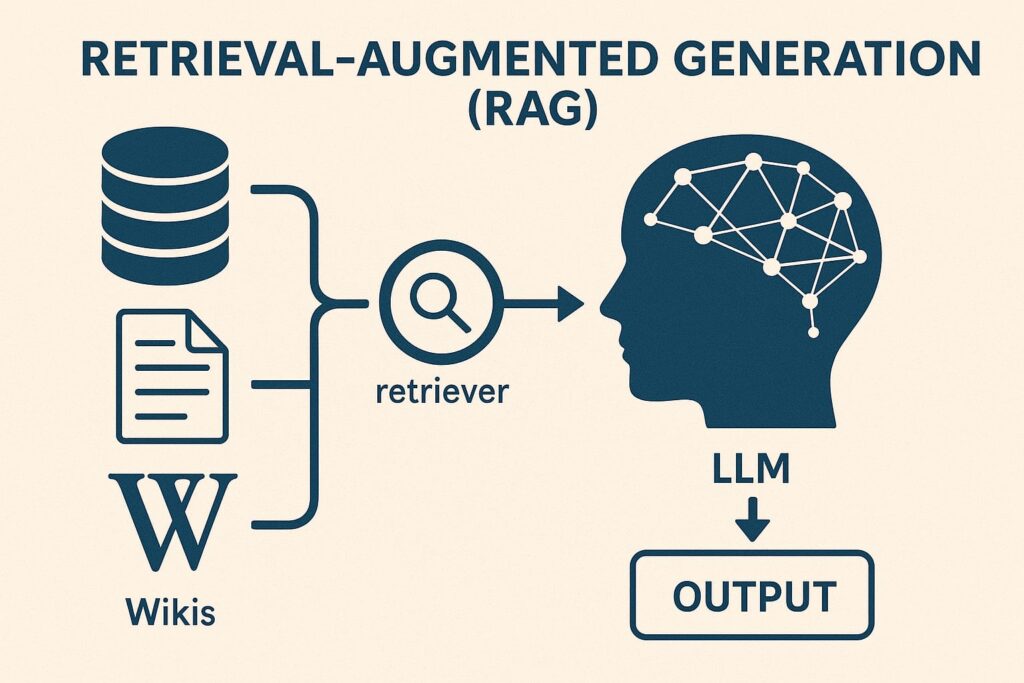

Para implementaciones prácticas, Patil recomienda utilizar bibliotecas como LangChain para realizar Generación Aumentada por Recuperación (RAG), que permite al modelo acceder a documentos externos durante la generación de respuestas.

pythonfrom langchain.document_loaders import WikipediaLoader

from langchain.text_splitter import RecursiveCharacterTextSplitter

from langchain.embeddings import OpenAIEmbeddings

from langchain.vectorstores import FAISS

from langchain.chat_models import ChatOpenAI

from langchain.chains import RetrievalQA

# Crear un retriever

retriever = vector_store.as_retriever(search_type="similarity", search_kwargs={"k": 3})

# Crear una cadena RetrievalQA

llm = ChatOpenAI(temperature=0, model_name="gpt-3.5-turbo")

qa_chain = RetrievalQA.from_chain_type(

llm=llm,

chain_type="stuff",

retriever=retriever,

return_source_documents=True,

)

Este enfoque permite al modelo acceder a conocimientos específicos de la empresa que no están presentes en sus datos de entrenamiento originales.

4. Evaluación rigurosa del modelo

Un aspecto crítico frecuentemente subestimado es la evaluación sistemática del rendimiento del modelo. A diferencia del software tradicional, «esto no es un código donde das algunos parámetros de entrada y recibes una salida fija que puedes comprobar», señala Patil.

Evaluación manual

La observación directa de las respuestas del modelo en un entorno controlado es un primer paso valioso. Patil comparte su experiencia: «Teníamos integrado un chatbot de Slack que estaba mejorado con RAG utilizando nuestras wikis y Jira. Una vez que añadimos el chatbot al canal de Slack, inicialmente supervisamos sus respuestas».

Sin embargo, este enfoque tiene limitaciones evidentes: «No puedes ganar confianza con pruebas manuales tan vagas».

Métricas cuantitativas de evaluación

Para una evaluación más rigurosa, Patil recomienda utilizar métricas estandarizadas como el puntaje ROUGE, que compara el texto generado con un texto de referencia ideal utilizando diferentes criterios:

- ROUGE-1: Evalúa coincidencias de palabras individuales

- ROUGE-2: Evalúa coincidencias de pares de palabras consecutivas

- ROUGE-L: Considera la subsecuencia común más larga

Para organizaciones que buscan un enfoque más estructurado, existen benchmarks externos como GLUE y SuperGLUE que ofrecen frameworks completos de evaluación.

5. Optimización y despliegue

La fase final consiste en optimizar el modelo para su despliegue en producción, equilibrando rendimiento y eficiencia. Patil destaca dos técnicas principales:

Cuantización de pesos

Reducir la precisión de los pesos del modelo puede disminuir significativamente los requisitos de memoria. «1 parámetro generalmente requiere 24 bytes de memoria del procesador. Por lo tanto, si eliges 1B parámetros, requerirán 24 GB de memoria del procesador», explica Patil.

La cuantización convierte estos valores de precisión alta a precisión más baja, reduciendo drásticamente los requisitos de almacenamiento sin comprometer significativamente el rendimiento.

Poda (Pruning)

Esta técnica consiste en eliminar pesos menos importantes del modelo, como aquellos cercanos o iguales a cero. Patil menciona tres enfoques:

- Reentrenamiento completo del modelo

- Técnicas PEFT como LoRA

- Poda post-entrenamiento

Estas optimizaciones son particularmente valiosas para despliegues en entornos con recursos limitados o para aplicaciones que requieren baja latencia.

Conclusión: Un enfoque pragmático para la implementación de LLMs

La incorporación de modelos de lenguaje en aplicaciones empresariales no requiere reinventar la rueda. Como concluye Patil, «puedes elegir un modelo pre-entrenado, como ChatGPT o FLAN-T5, y construir sobre él. Construir tu propio modelo pre-entrenado requiere experiencia, recursos, tiempo y presupuesto».

El enfoque más eficiente para la mayoría de las organizaciones consiste en seleccionar un modelo base adecuado, personalizarlo para su caso de uso específico mediante técnicas como RAG, evaluarlo rigurosamente y optimizarlo para el despliegue.

Este proceso metodológico permite a las empresas aprovechar la potencia de los LLMs sin caer en la trampa de soluciones excesivamente complejas o ineficientes, garantizando que la inversión en IA generativa se traduzca en mejoras tangibles en procesos, productos y servicios.

Fuente: Prasann Pradeep Patil, «A Step-By-Step Guide To Powering Your Application With LLMs», Abril 2025.

Por Julio Hofflinger

https://www.linkedin.com/in/julio-hofflinger/